Ontdek alle mogelijkheden met ApplePY. Bekijk alle features

Nadat Google heeft aangekondigd dat de Helpful Content Updated bedoeld was om content dat door AI geschreven is te straffen, werd de impacht van de HCU-update pas na 2 weken zichtbaar. Verwachtingen dat content dat door AI geschreven is hard getroffen zou worden, werden niet waargemaakt. Bij enkele voorbeelden, waar het overduidelijk was dat dit geschreven was door AI, heeft de HCU-update impact gemaakt.

Een voorbeeld van slecht gemaakte AI-content is throughtheclutter.com, een domein dat profielen van beroemdheden en de films waarin ze speelden publiceert. Het is de kwaliteit van de content die door de HCU-update wordt bestraft.

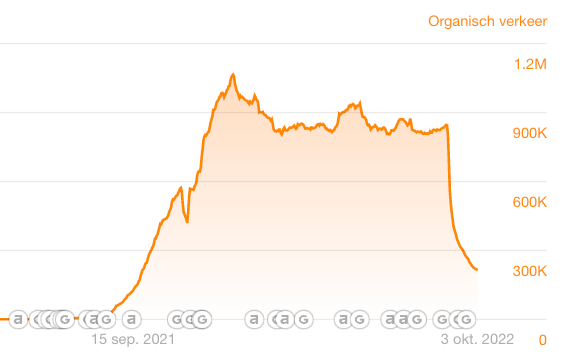

Op het hoogtepunt bereikte throughtheclutter.com ongeveer 1M maandelijkse bezoekers. Op 30 augustus begonnen de ranking sterk te dalen. Een week later daalde het verkeer tot bijna 0.

Voordat je zelfs maar naar het verkeer kijkt, kun je zien dat er iets aan de hand is met het domein door te kijken naar de tekstopmaak #walloftext.

De SEO-zichtbaarheid van het domein (screenshot hieronder) toont de ontwikkeling voor websites die agressief schalen met AI-content: een plotselinge stijging, een plateau, en een scherpe daling.

Om te bewijzen dat de content door AI is gemaakt, analyseren we de content met verschillende AI-detectietools.

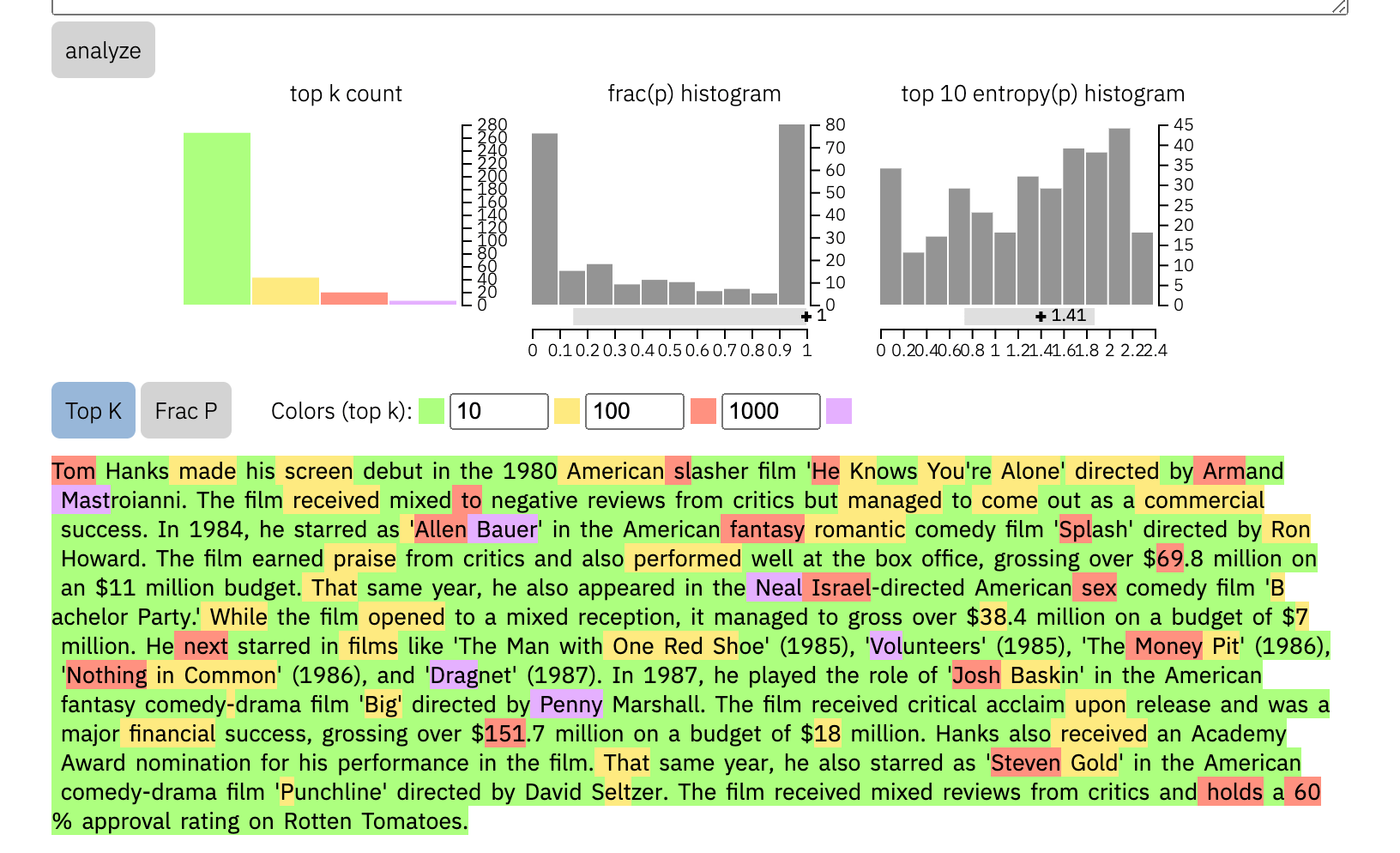

De eerste tool is GLTR, een tool van IBM Watson en Harvard NLP, gebaseerd op GPT-2. Het meet de voetafdruk van een stuk tekst om in te schatten hoe groot de kans is dat deze automatisch gegenereerd is.

Je ziet dat de tekst van througtheclutter.com veel minder rode en paarse woorden heeft dan de tekst van Wikipedia (screenshot hieronder).

Rode en paarse woorden zijn "verrassend" in GLTR's GPT-2 model, wat betekent dat het minder waarschijnlijk is dat ze door een AI worden voorspeld. Hoe meer groene woorden een tekst bevat, hoe groter de kans dat de tekst door AI is geschreven.

Als we nog een stap verder gaan en de histogrammen van de top 10 woordvoorspellingen vergelijken, zien we een heel ander beeld.

De content van Wikipedia daarentegen heeft een laag vertrouwen in de ondergrenzen en een hoger vertrouwen in de bovengrenzen, wat betekent dat de tekst moeilijker te voorspellen is voor het GPT-2 model. Het is waarschijnlijker dat de content door mensen is gemaakt.

De transformatortechnologie in GPT, wat staat voor Generative Pre-trained Transformer, kan tekst voorspellen op basis van eerdere woorden. Google kan AI-content detecteren op basis van hoe "voorspelbaar" tekst is - vooral in vergelijking met alle andere content over hetzelfde onderwerp in zijn corpus.

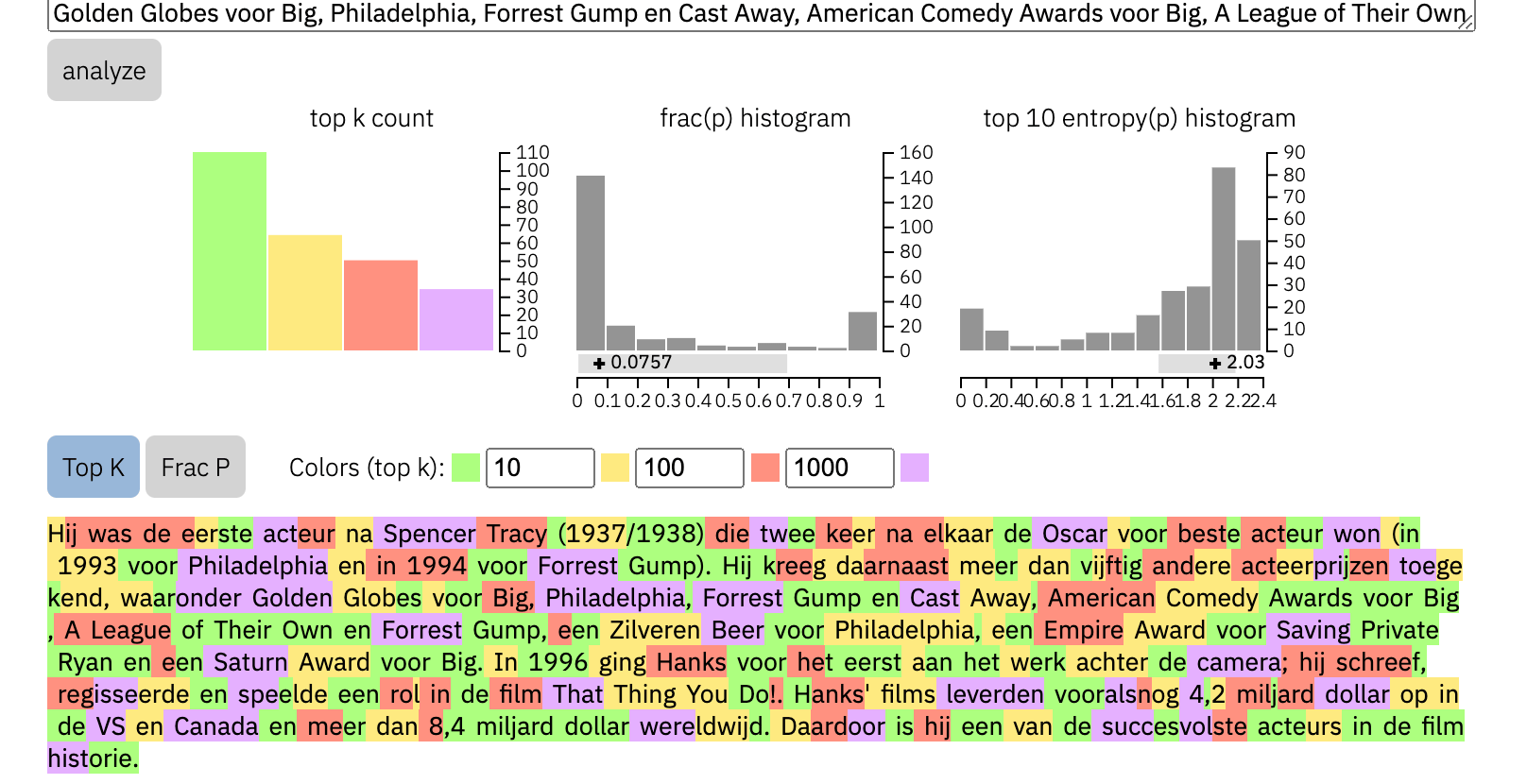

De tweede AI-inhouddetectietool, Huggingface's GPT-2 Output Detector, is ook gebouwd op GPT-2, maar gebruikt 1,5b parameters in plaats van GLTR's 117M. De demo analyseert alleen de eerste 510 tokens, wat genoeg data is voor deze casestudy.

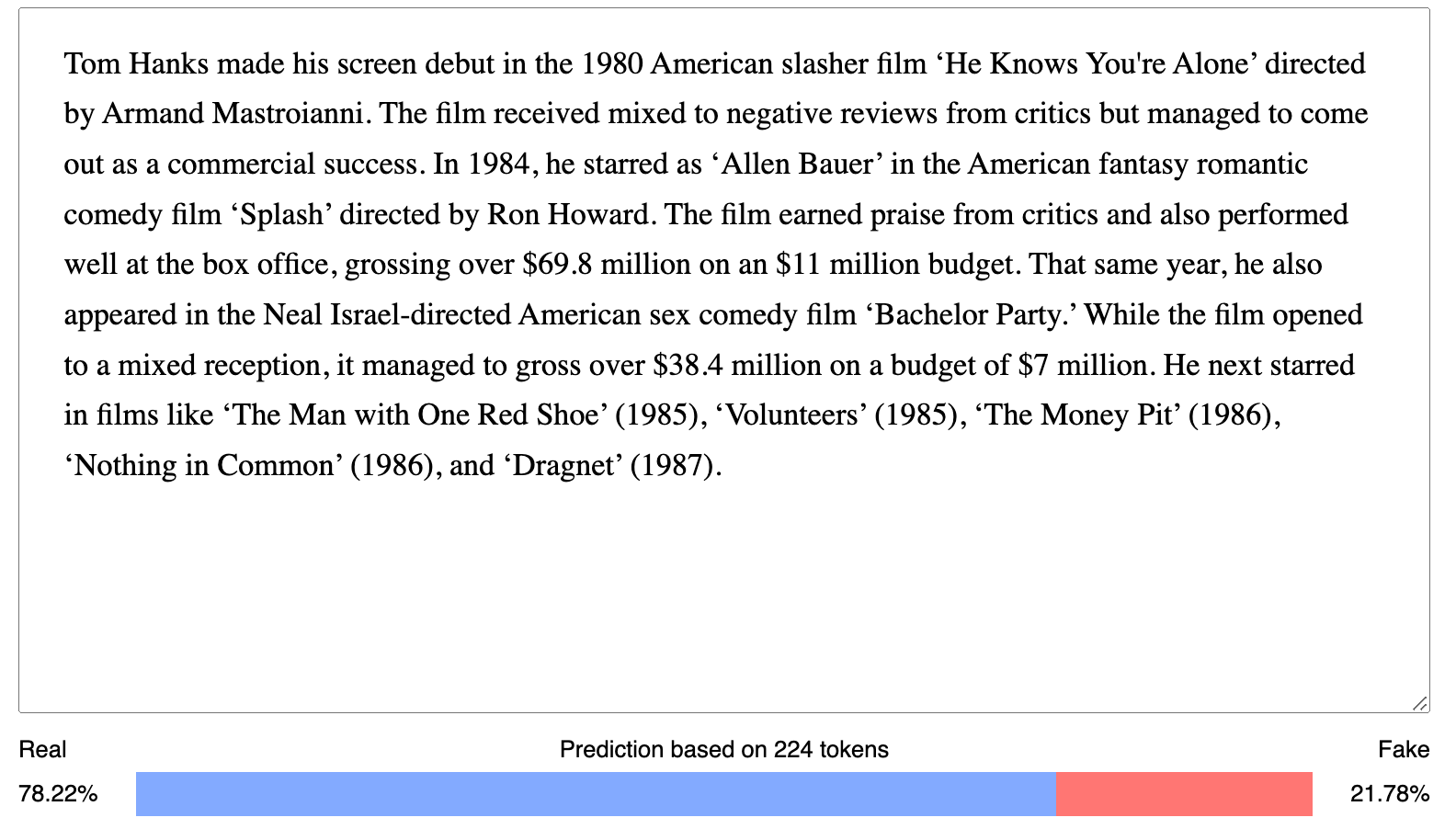

De Output Detector vindt een kans van 21,78% dat de tekst van throughtheclutter.com door AI geschreven is.

Huggingface's Output Detector vindt 21,78% kans op AI-content. Dat lijkt op het eerste gezicht laag, maar het is eigenlijk vrij hoog vergeleken met de 0,02% waarschijnlijkheid voor de tekst van Wikipedia.

Veel bedrijven gebruiken AI-content, maar zijn maar weinig die daar echt voor gestraft zijn. Dat heeft alles te maken met het feit dat er bij content dat geschreven is door AI, weinig tot niets is aangepast, geen menselijke touch hebben gekregen voordat ze gepubliceerd werden. Google kan steeds beter onderscheiden wat door mensen en door AI geschreven is.

In plaats daarvan straft Google de extreem lage kwaliteit content. De strategische zet voor bedrijven is niet om AI helemaal achterwege te laten, maar om tools zoals de openbare OpenAI GPT-2 bibliotheek te gebruiken in hun workflows voor het maken van content om de voorspelbaarheid van tekst te verminderen en de kans op organisch verkeer te vergroten.

Ongeacht wie of wat de content creëert. De tekst op throughtheclutter.com is niet slecht omdat de content gemaakt is door AI, maar omdat de opmaak en presentatie van de data geen waarde bieden voor de bezoeker.

Op dit moment zijn drie open-source software die wij bewust in de gaten houden om gegenereerde content te detecteren. Grover, een fake-news detectietool, GLTR en de GPT-2 detectietool gebouwd met RoBERTa.